Индексация сайта: как управлять индексом

наш канал в

наш канал в  ЯНДЕКС.ДЗЕН.

ЯНДЕКС.ДЗЕН.

Важной составляющей при поисковой оптимизации является работа с внутренними факторами. К таким факторам относят, в том числе, управление индексацией ресурса - настройка его взаимодействия с роботами поисковых систем. Данный вопрос функционирования сайта необходимо решать еще на этапе проектирования, что позволит избежать проблем с продвижением в дальнейшем.

Что такое индексация сайта и краулинговый бюджет?

Индексация сайта - это процесс обхода страниц веб-ресурса поисковыми роботами и внесение полученной информации в базу поисковых систем, и для того, чтобы ресурс появился в выдаче Яндекса или Google необходимо, чтобы он был просканирован и добавлен в их индекс.

Поисковые роботы посещают регулярно страницы ресурса, но то, с какой периодичностью они это делают, зависит от нескольких факторов:

- частота изменения контента;

- количество страниц на сайте;

- объем трафика.

О новых страницах поисковые роботы узнают из ссылок, которые появляются на ранее известных им документах, а также по трафику на них с различных источников.

При этом необходимо учитывать, что за один заход робот обрабатывает некоторое количество страниц сайта. Такое явление связано с тем, что поисковые роботы не хотят перенагружать сервер своими запросами. Но каким образом определяется этот лимит загружаемых документов?

В начале 2017 года представитель компании Google Гэри Илш рассказал про такое понятие как Краулинговый бюджет, который объединяет в себе такие показатели: скорость сканирования сайта и краулинговый спрос (количество документов, которое хочет обойти робот Google, основанное на популярности ресурса и актуальности контента). Под краулинговым бюджетом Google подразумевает количество страниц сайта, которые может обойти Googlebot.

Внутренние факторы сайта, которые уменьшают показатель краулингового бюджета (по версии Google):

- доступные к индексации документы, в адресе которых указаны идентификаторы сессий, переменные фильтрации или поиска, UTM-метки;

- дубли страницы;

- документы с 404-откликом сервера;

- страницы с низкокачественным и спамным контентом.

Способы управления индексацией сайта

Для того чтобы оптимизировать расход краулингового бюджета необходимо корректно управлять индексацией сайта - давать возможность индексировать роботам только те страницы, которые важны для продвижения ресурса.

Канонические страницы

С помощью настройки канонического адреса (canonical) можно явно поисковым системам указать, какая страница является предпочтительной для индексации. Настраивать атрибут canonical необходимо в том случае, если на сайте присутствуют документы с одинаковым содержанием:

- страницы пагинации;

- страницы с UTM-метками;

- страницы фильтрации;

- и др

Для настройки канонических страниц необходимо в разделе head указать следующий код:

Если страница должна участвовать в поиске, то в атрибуте href указывается ее url, если не должна и является полным или частичным дублем, то в атрибуте href указывается адрес канонического документа.

Robots.txt

С помощью файла robots.txt, который находится в корне сайта, можно управлять поисковыми роботами:

- Директива Disallow закрывает от индексации указанные страницы;

- User-Agent позволяет указать поисковую систему, для которой написаны инструкции индексации;

- Crawl-delay задает частоту обращения роботов к страницам ресурса (Google пропускает данную инструкцию);

- Clean-param запрещает к индексации страницы с указанными динамическими параметрами.

Подробнее о настройке файла robots.txt можно найти в нашей статье: https://www.altera-media.com/information/expert/pravilnaya-nastrojka-robots-txt/.

Мета-тег Robots

Данный мета-тег предназначен для управления индексацией конкретной страницы. Для настройки мета-тега необходимо в разделе head указать:

Список параметров мета-тега robots:

- index — разрешение на индексирование документа;

- noindex — запрет на индексирование документа;

- follow — разрешение на следование по ссылкам на странице;

- nofollow — запрет на следование по ссылкам на странице;

- all — равносильно указанию content=”index, follow”;

- none — равносильно указанию content=”noindex, nofollow”.

Отсутствие мета-тега в коде страницы расценивается как автоматическое разрешение на индексацию документа и следование по ссылкам.

Важно учитывать, что при закрытии страницы от индексации таким образом - робот все равно “тратит” свой краулинговый бюджет на ее прочтение, лучше всего данный мета-тег использовать для запрета перехода по ссылкам.

Какие страницы необходимо закрывать от индексации?

От индексации поисковыми системами следует закрывать следующие типы страниц:

- Для страниц пагинации следует указывать канонический адрес (не стоит закрывать такие их с помощью мета-тега robots или robots.txt: широкий ассортимент - один из важных коммерческих факторов);

- Технические страницы (без полезного контента) следует закрывать в robots.txt;

- Страницы персональной информации (личный кабинет, регистрации и др.) стоит закрывать в robots.txt:

- Для страниц, которые формируются при сортировке товаров в каталоге, стоит указывать канонический адрес;

- Страницы версии для печати стоит закрывать в robots.txt;

- Страницы с результатами поиска по сайту стоит закрывать в robots.txt и с помощью тега robots, если их нельзя оптимизировать под получение дополнительного трафика.

Грамотное управление индексацией поможет оптимизировать краулинговый бюджет и направить лимиты на продвигаемые страницы ресурса.

Проверка проиндексированных страниц

Для проверки корректной индексации ресурса можно воспользоваться несколькими способами.

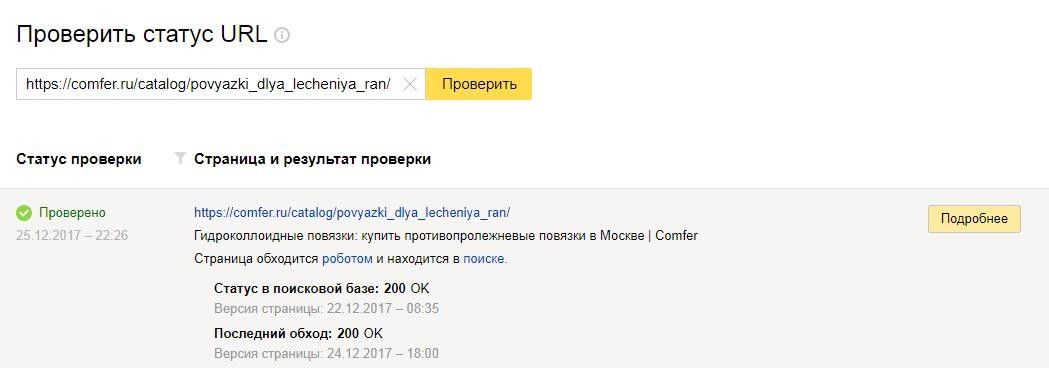

Проверка индексации в панелях Вебмастера Яндекса и Google

В Яндекс Вебмастере в разделе Индексации есть возможность проанализировать индексацию ресурса:

- просмотреть общее количество страниц, проиндексированных поисковой системой;

- настроить отслеживание изменений на важных страницах (изменение ответа сервера, выпадение из индекса);

- проверить статус индексации отдельных документов:

- узнать причины выпадения страниц из поиска. Причинами могут быть:

- наличия дубля;

- неверный отклик;

- неканоническая;

- запрет для индексации в robots.txt

Владея этой информацией можно оперативно устранять ошибки на сайте для возврата необходимых страниц в индекс поисковой системы Яндекс.

Google, к сожалению, не обладает столь удобным инструментом для анализа проиндексированных документов. С помощью консоли Google для вебмастеров можно посмотреть:

- Количество проиндексированных страниц;

- Количество закрытых страниц в файле robots.txt:

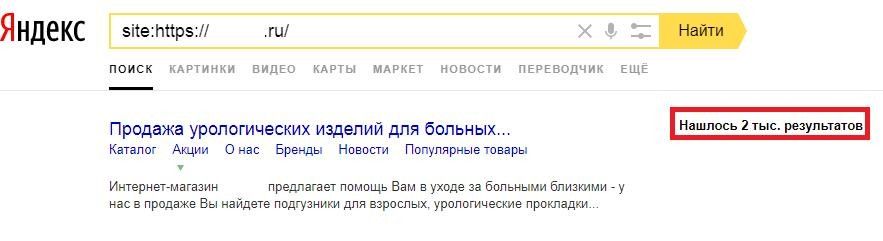

Использование поисковых операторов

Поисковые системы разработали специальные поисковые операторы, позволяющие уточнять поисковой запрос. Например, с помощью оператора «site:» можно узнать приблизительное количество проиндексированных страниц.

Большая разница между количеством проиндексированных страниц в Яндексе и в Google может свидетельствовать о том, что у сайта проблемы с технической оптимизацией.

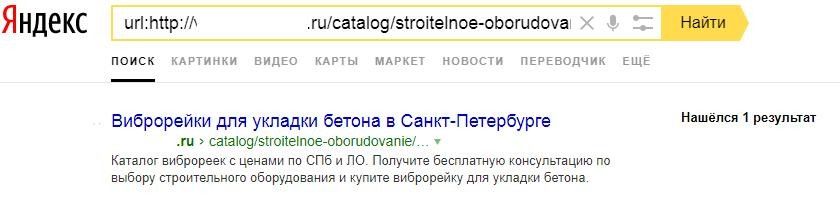

С помощью оператора url: в Яндексе можно проверить проиндексирована ли конкретная страница:

Проверка индексации с помощью RDS бара

Панель инструментов RDS бар — это плагин для браузеров Google Chrome и Mozilla Firefox, который в браузере отображается в виде дополнительной панели инструментов. Данный плагин позволяет быстро просмотреть основные показатели ресурса:

- количество проиндексированных страниц в Яндексе и в Google;

- проиндексирована ли текущая страница в Яндексе и в Google;

Программы для проверки индексации

Для автоматизации процесса анализа внутренних ошибок веб-ресурса и проблем индексации существуют специальные инструменты - парсеры сайта и индекса поисковых систем:

- Netpeak Spider - программа позволяет проверить отклики страниц, посмотреть канонические адреса, закрыта ли страница в robots.txt или с помощью мета-тега robots:

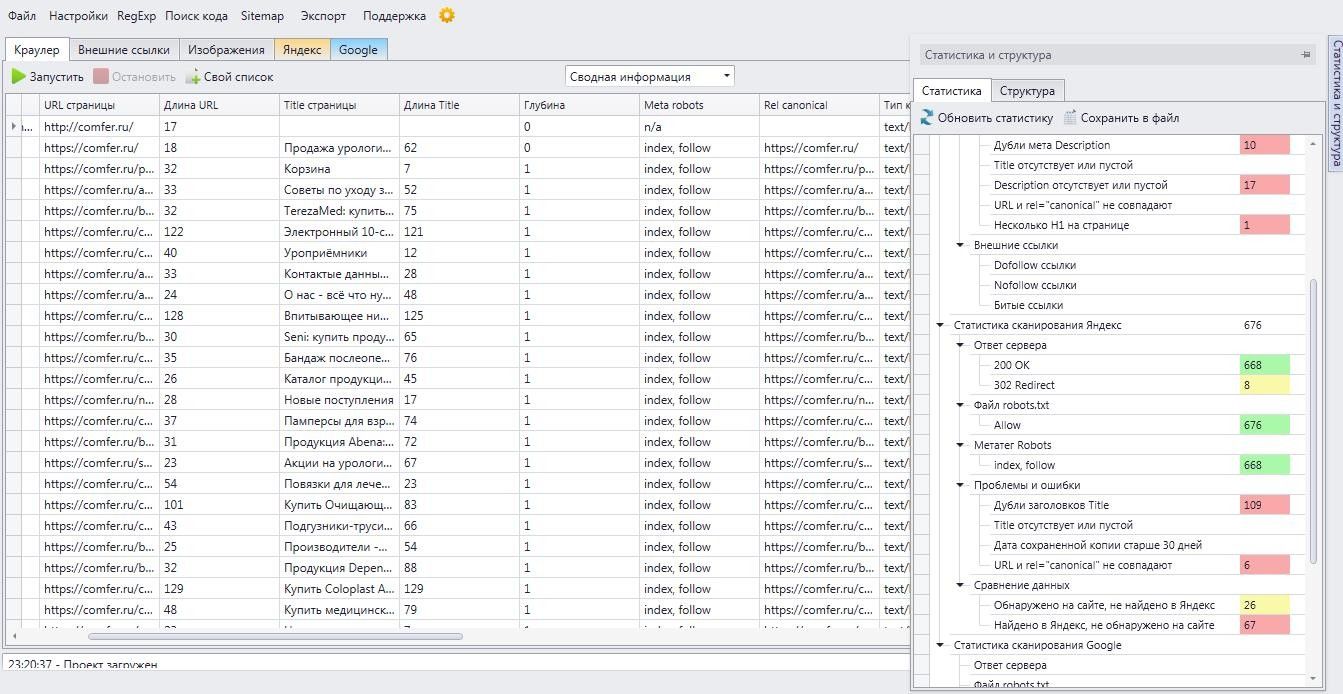

- Comparser - специализированная программа для глубокого анализа индексации сайта, которая позволяет выполнять следующие операции:

- сканирование страниц всего веб-ресурса (откликов и канонических адресов);

- сканирование индекса поисковых систем (Яндекс и Google);

- поиск страниц, которые есть в индексе поисковых систем, но на сайте на них отсутствуют внутренние ссылки;

- автоматическое удаление ненужных страниц из индекса Яндекса и Google.

Причины выпадения страниц из индекса

Большое количество выпавших посадочных страниц из поиска Яндекса и Google приводит к падению позиций сайта и трафика. Можно выделить несколько основных причин выпадения страниц из индекса поисковых систем:

- 301 или 302 отклик (настроены редиректы на другой документ);

- Наличие дублей (например, страницы пагинации, фильтрации, сортировки и другие типы страниц, где дублируются мета-данные и контент);

- Ошибочное закрытие раздела сайта или страницы в файле robots.txt или мета-тегом robots;

- 404 отклик;

- 5xx отклик, говорящий о том, что есть сбои в работе хостинга или CMS, из-за чего страницы длительное время недоступны для роботов поисковых систем.

Для предотвращения выпадения посадочных страниц ресурса из индекса поисковых систем следует следить за технической оптимизацией сайта и своевременно устранять возникающие ошибки. Но если, поисковая система удалила страницу из поиска, то следует воспользоваться следующим алгоритмом:

- Определить причину выпадения из индекса;

- Устранить причину;

- Отправить выпавшую страницу на индексацию (переиндексацию).

Методы ускоренной индексации

Если страница новая или отсутствует в индексе по какой-то причине (и причина выпадения из индекса исправлена), то с помощью следующих способов, можно ускорить добавление ее в индекс:

- Указание страницы (страниц) в файле sitemap.xml с датой обновления и приоритетом на индексирование;

- Отправка в инструмент “Переобход страниц” в Яндексе;

- Размещение ссылок на документ на внешних ресурсах;

- Размещение ссылок на документ в социальных сетях;

- Получение моментального трафика с хорошей активностью, где источником трафика может быть даже e-mail-рассылка;

- Корректная настройка внутренней перелинковки на сайте.

Заключение

Управление индексацией - важная часть работы при продвижении. В отличие от работы с внешними факторами поисковой оптимизации - возможность влиять на индексацию страниц всегда доступна и изменения быстрее отражаются в индексе поисковых систем, но лучше всего предусмотреть грамотное взаимодействие сайта с поисковыми роботами еще на этапе разработки ресурса.

Важно вовремя отслеживать все внутренние ошибки на сайте, чтобы иметь возможность быстро их устранить до того, как поисковые системы удалят страницы из индекса. А если это уже произошло - необходимо оперативно отправить выпавшие (либо новые) страницы на индексацию.

Вы дочитали статью! Отличная работа!

- В некоторых нюансах продвижения сайтов сложно разобраться без опыта. Вы можете доверить продвижение вашего сайта нам. Отправьте заявку и мы изучим ваш сайт и предложим эффективную стратегию продвижения вашего бизнеса в сети.

- Подпишитесь на нашу рассылку - ежемесячно мы публикуем статьи про SEO-продвижение, онлайн-маркетинг, контекстную рекламу, новости отрасли и многое другое.

- Понравилась статья? Поделитесь ссылкой на статью в социальных сетях - возможно, статья окажется полезной для ваших друзей и коллег.

- Хотите стать экспертом?

Предлагаем вам почитать другие наши статьи, вот некоторые из них:

- Ищете работу? Приглашаем вас в наш дружный и профессиональный коллектив: интересные задачи, перспективы профессионального и личностного роста, одна из самых опытных команд в области SEO-продвижения в Санкт-Петербурге. Наши вакансии.